计算机系研究团队在大规模语言预训练模型前沿领域取得新进展

2024/04/12

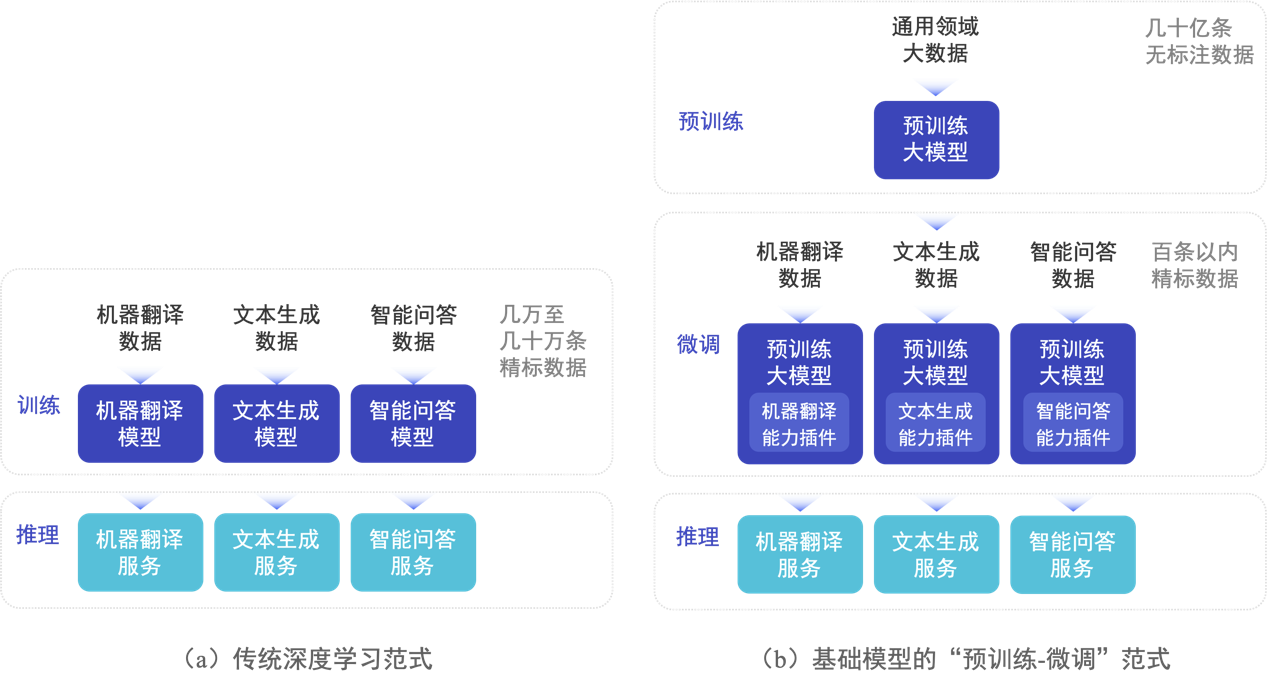

2018年以来,预训练语言模型(PLM)及其“预训练-微调”方法已成为自然语言处理(NLP)任务的主流范式,该范式先利用大规模无标注数据通过自监督学习预训练语言大模型,得到基础模型,再利用下游任务的有标注数据进行有监督学习微调模型参数,实现下游任务的适配(图1)。越来越多实验表明:规模越大的模型不仅在已知任务上有着更好的表现,同时展现出完成更复杂的未知任务的强大泛化能力,近年出现的GPT-3、ChatGPT等均为大规模预训练模型的代表。然而,现有对大规模预训练模型的全部参数进行微调实现任务适配的做法,会消耗大量的GPU计算资源和存储资源,严重限制大模型的应用场景。为了应对该挑战,参数高效微调(Parameter-efficient Fine-tuning)方法逐渐受到关注。与全参数微调相比,参数高效微调方法冻结预训练模型99%以上的参数,仅利用少量下游任务数据微调少于1%模型规模的参数,作为模型插件实现大模型对下游任务的适配,达到媲美全参数微调的性能,并显著降低微调过程的计算和存储开销。

图1.基础模型的“预训练-微调”范式与传统深度学习的对比

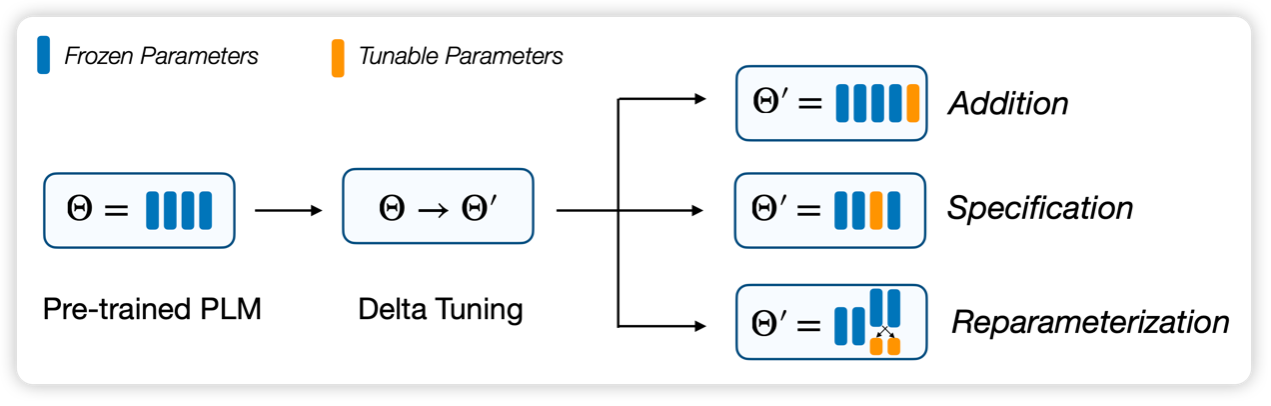

研究团队提出,参数高效微调方法的本质是在对“增量参数”(Delta Parameters)进行调整,因此将此类方法命名为“增量微调”(Delta Tuning),并基于统一的分析框架对增量微调现有方法进行梳理总结,将现有方法分为三类(如图2所示):添加式(Addition-based)、指定式(Specification-based)和重参数化(Reparameterization-based)方法。为了指导后续的模型架构和算法设计,团队还进一步从参数优化和最优控制两个角度,提出了增量微调的理论框架,为探索和解释增量微调的内在机理提供了可行方案。

图2.统一视角的增量微调框架

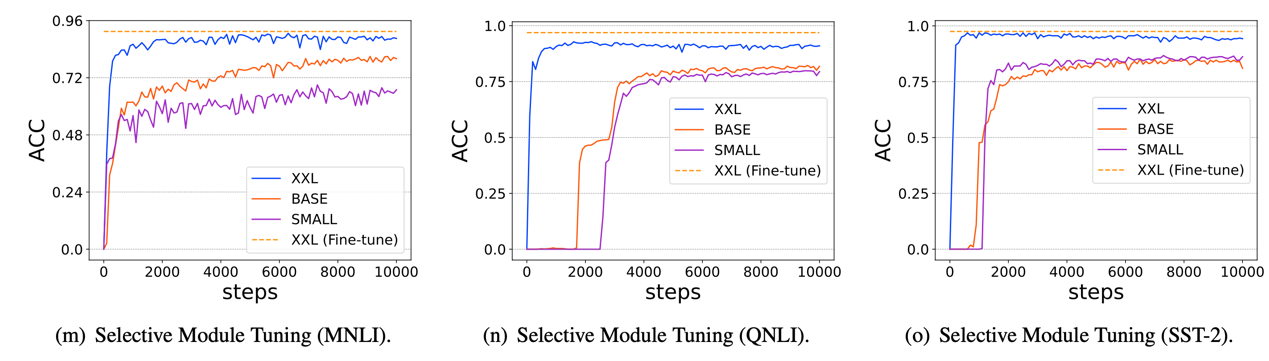

该研究工作选择了超过100个自然语言处理任务,对主流增量微调方法进行了全面细致的性能比较和分析,得出多项重要结论,例如:(1)基础模型随着参数规模的不断增大,在性能显著提高的同时,不同增量微调方法的差异急剧减少(图3),最少仅需要优化万分之八的模型参数即可完成适配;(2)不同增量微调方法可以进行并行或者串行的组合从而达到更优的性能,表明了分布在模型参数空间中的智能能力可以进行组合和泛化;(3)增量微调方法具备良好的任务级别的迁移能力,完成特定任务的“能力”可以表示为轻量级参数化的形式,可以在不同基础模型和不同用户之间共享。以上研究表明,增量微调是基础模型的重要特性,上述结论将加深对基础模型的认识,为其创新研究与应用提供重要支撑。

图3.随着基础模型参数规模的增大,增量微调方法可以更有效地激发模型性能

研究团队自2018年以来坚持开展语言大模型创新研究,并坚持建设OpenBMB开源社区,致力于构建大规模预训练模型全流程高效计算工具体系,相关工作在全球最大的开源社区GitHub上累计获得超过4000星标关注,曾获自然语言处理领域著名国际会议ACL 2022最佳系统演示论文奖等荣誉。研究团队基于该论文成果研制发布了开源工具包OpenDelta,是OpenBMB开源社区的重要组成部分,可支持研究者和开发者灵活高效地在各类预训练模型上实现和应用增量微调方法。研究团队认为,增量微调技术将是基础模型适配特定任务、场景和用户的重要范式,可更有效地激发以ChatGPT为代表的大规模预训练模型的性能。

相关研究成果“面向大规模预训练语言模型的参数高效微调”(Parameter-efficient Fine-tuning of Large-scale Pre-trained Language Models)于3月23日被国际知名期刊《自然·机器智能》(Nature Machine Intelligence)作为封面文章发表。

该研究成果由清华大学计算机系孙茂松、李涓子、唐杰、刘洋、陈键飞、刘知远和深圳国际研究生院郑海涛等团队师生共同完成,清华大学计算机系副教授刘知远、深圳国际研究生院副教授郑海涛、计算机系教授孙茂松为该文章的共同通讯作者,清华大学计算机系2018级博士生丁宁与2019级博士生秦禹嘉为该文章的共同第一作者。该研究得到科技部科技创新2030“新一代人工智能”重大项目、国家自然科学基金、北京智源人工智能研究院、清华大学国强研究院的支持。

文章来源清华大学新闻,分享只为学术交流,如涉及侵权问题请联系我们,我们将及时修改或删除。

-

2026年第八届计算机科学与技术在教 109

-

2026年3月高含金量国际学术会议合 88

-

2026资源、化学化工与应用材料国际 1265

-

2026年人工智能教育技术与数据科学 246

-

2026年图像处理与数字创意设计国际 1041

-

2026年机械工程,新能源与电气技术 5524

-

2026年材料科学、低碳技术与动力工 1312

-

2026年第二届无线与光通信国际会议 2080

-

第七届多组学科研与临床应用大会 02-05

-

2026年制药学、生物技术与植物学国 02-04

-

2026年节能技术、低碳发展与可持续 02-04

-

2026年导航控制、传感技术与卫星应 02-04

-

2026年经济转型与商业文化国际学术 02-04

-

2026年体育科学、运动健康与创新管 02-04

-

2026创意城市、设计与社区建设国际 02-04

-

2025年两院院士增选有效候选人4066

-

2025最新JCR分区及影响因子10070

-

好学术:科研网址导航|学术头条分5098

-

2025年国际期刊预警名单发布!5129

-

2025年中科院期刊分区表重磅发16711

-

中国科协《重要学术会议目录(2010250

-

吉林大学校长张希:学术会议中的提6245

-

bbrc期刊,bbrc期刊处于S02-03

-

siam期刊,siam期刊发的最02-03

-

了望期刊,瞭望期刊02-03

-

共享经济期刊,共享经济学术论文02-03

-

期刊代理网,从哪里找期刊代理02-03

-

light期刊,Light期刊综02-03

-

传承 期刊,传承期刊投稿点评02-03

-

期刊勘误,期刊勘误时会索要原始数02-03

-

广州市锐博生物科技有限公司 2435

-

武汉海讯科技会务有限公司 18638

-

同济大学1239号 18289

-

清华大学 8228

-

洛阳青创文化传播有限公司 8293

-

南京普世朗会展服务有限公司 24279

-

中华医学会行为医学分会 18369

-

广东省珠海市当当大道 18246

-

陕西省榆林市榆林学院 2426

-

江苏亨威实业集团 21307

-

VDSGER 2072

-

中国抗癌协会肿瘤标志专委会 8161

-

恒信通讯公司 21329

-

iwemse2018 24317

-

杨浦区四平路总工会 18404

-

北京中经蓝山文化交流有限公司 18255

-

浙江理工大学 23296

-

厦门理工学院 21296

-

DD 8522

-

拉萨旭日会议服务有限公司 21273

651

651